Новость декабря и следующих 100 лет развития компьютерной техники

IBM раскрыла планы развития квантовых компьютеров на ближайшие 10 лет: системы на 100 000 кубитов и с коммерческой ценностью

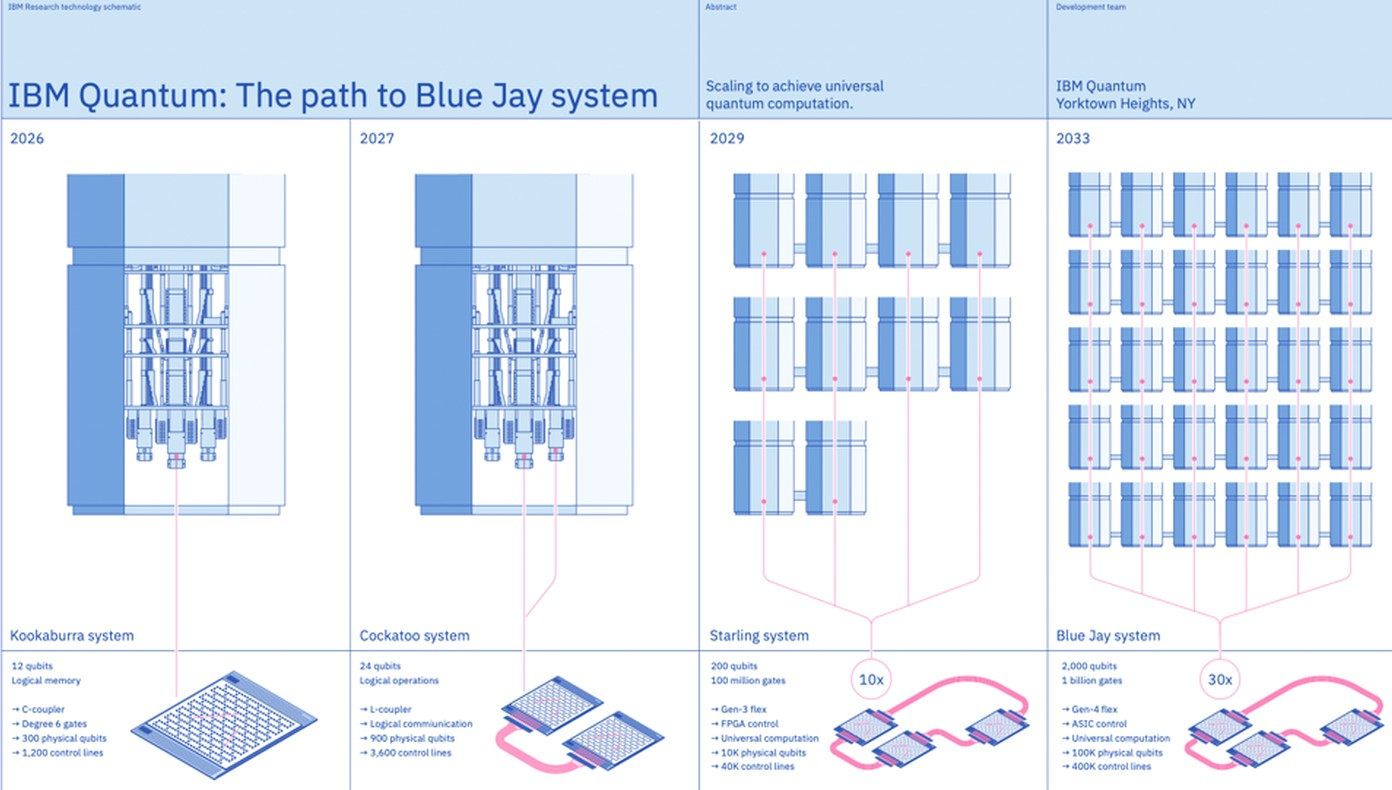

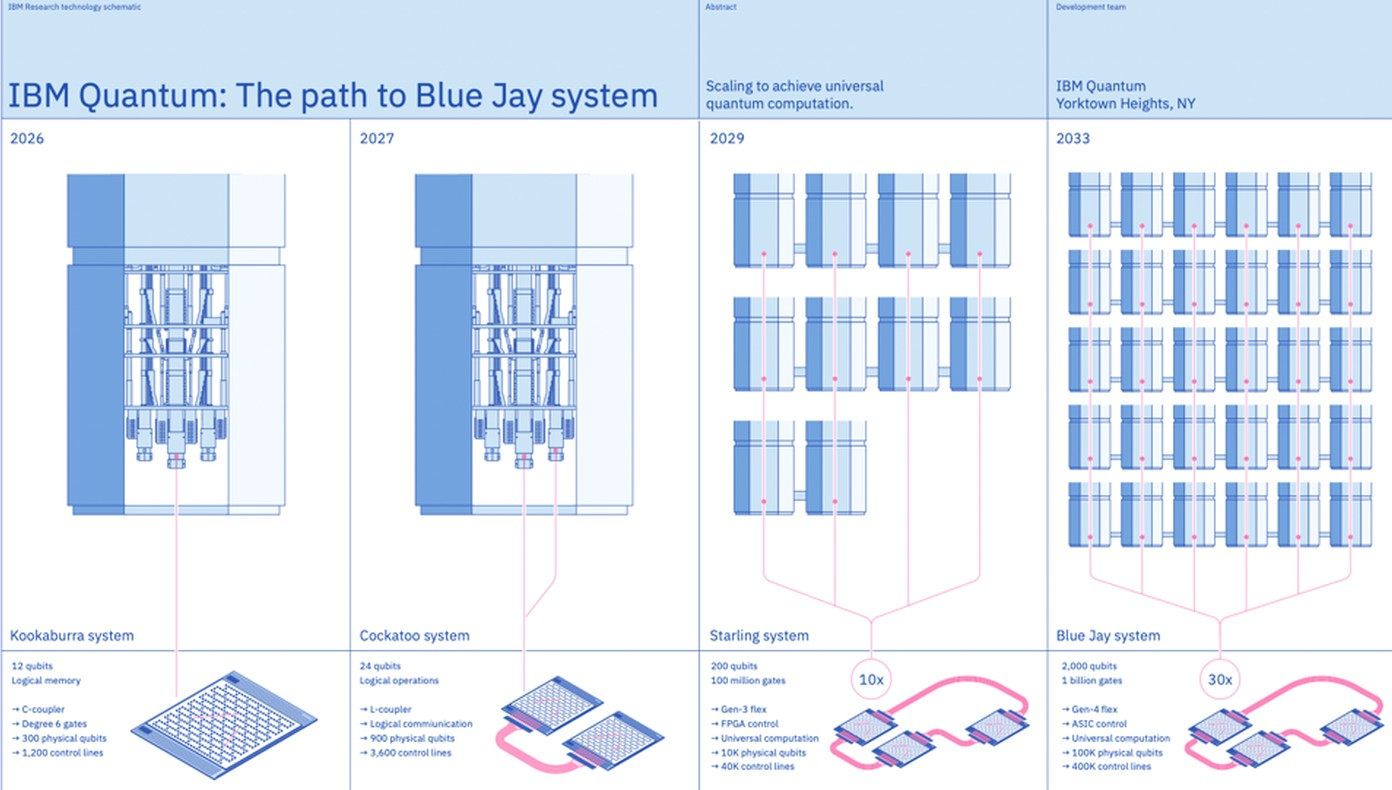

На саммите IBM Quantum исследователи анонсировали квантовый компьютер Quantum System Two на базе трёх процессоров IBM Heron и поделились дальнейшими планами по масштабированию квантовых систем с уменьшением ошибок, а также разработке программного обеспечения для них. IBM объявила о своём намерении преодолеть порог в 100 000 кубитов. В случае реализации этих планов, IBM может создать первую в мире платформу для универсальных квантовых вычислений.

Источник изображений: IBM

Квантовые вычисления используют свойства субатомных частиц, которые позволяют им находиться в разных состояниях одновременно. Благодаря этому квантовые машины могут одновременно выполнять большое количество вычислений и потенциально решать проблемы, выходящие за рамки возможностей традиционных компьютеров. Но кубиты, на которых основаны системы, нестабильны и сохраняют свои квантовые состояния лишь в течение очень коротких периодов времени, внося ошибки или «шум» в вычисления.

Использование возможностей квантовой механики — непростая задача. Квантовые системы требуют чрезвычайно низких температур, хрупки по своей природе и подвержены декогеренции. Точное манипулирование кубитами и измерение их состояний является серьёзной проблемой, а для успешного масштабирования квантовой системы частоту ошибок необходимо снизить с одной на тысячу до одной на миллион.

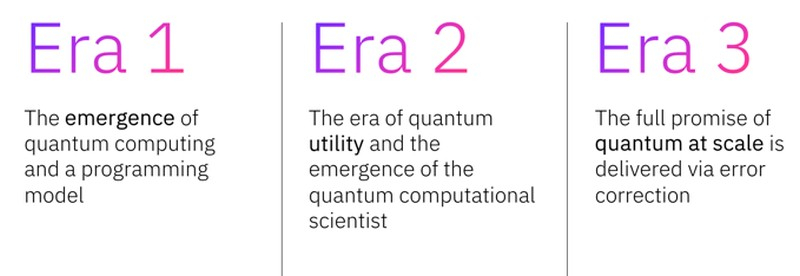

IBM заявила, что новые научные достижения её систем ознаменовали конец первой, экспериментальной фазы разработки, длившейся последние семь лет. Эта фаза ознаменовалась соединением достаточного количества кубитов вместе для проведения вычислений, разработкой способов управления кубитами для практического измерения их состояний и созданием первых квантовых алгоритмов.

По мнению IBM, сейчас человечество вступило во вторую фазу. Исследования сосредоточатся на характеристиках квантового оборудования, уменьшении и коррекции ошибок, а также проверке работоспособности приложений. На сегодняшний день IBM опубликовала около 2595 исследовательских работ со своими идеями и достижениями в этой области. К концу 2024 года компания планирует создать восемь центров квантовых вычислений в США, Канаде, Японии и Германии, чтобы обеспечить широкий доступ к Quantum System Two для исследователей.

Третья фаза должна расширить возможности масштабирования и обеспечить исправление ошибок. В IBM уверены, что достижение требуемого уровня коррекции ошибок ближе, чем представлялось ранее. Эта уверенность основана на новых исследованиях, в частности, на новой технологии межсоединений, обеспечивающей беспрецедентное масштабирование квантовых систем с тысячами кубитов.

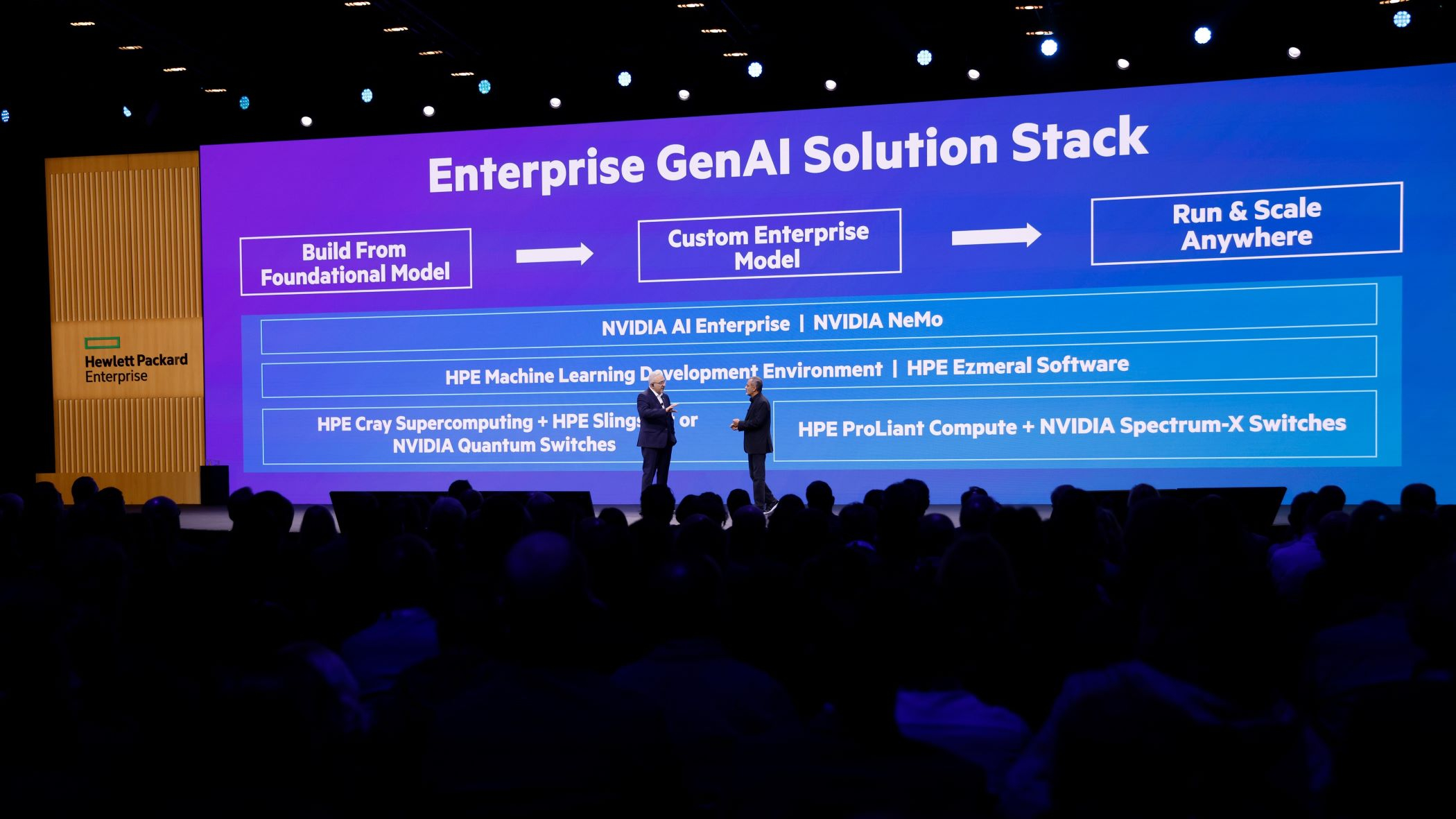

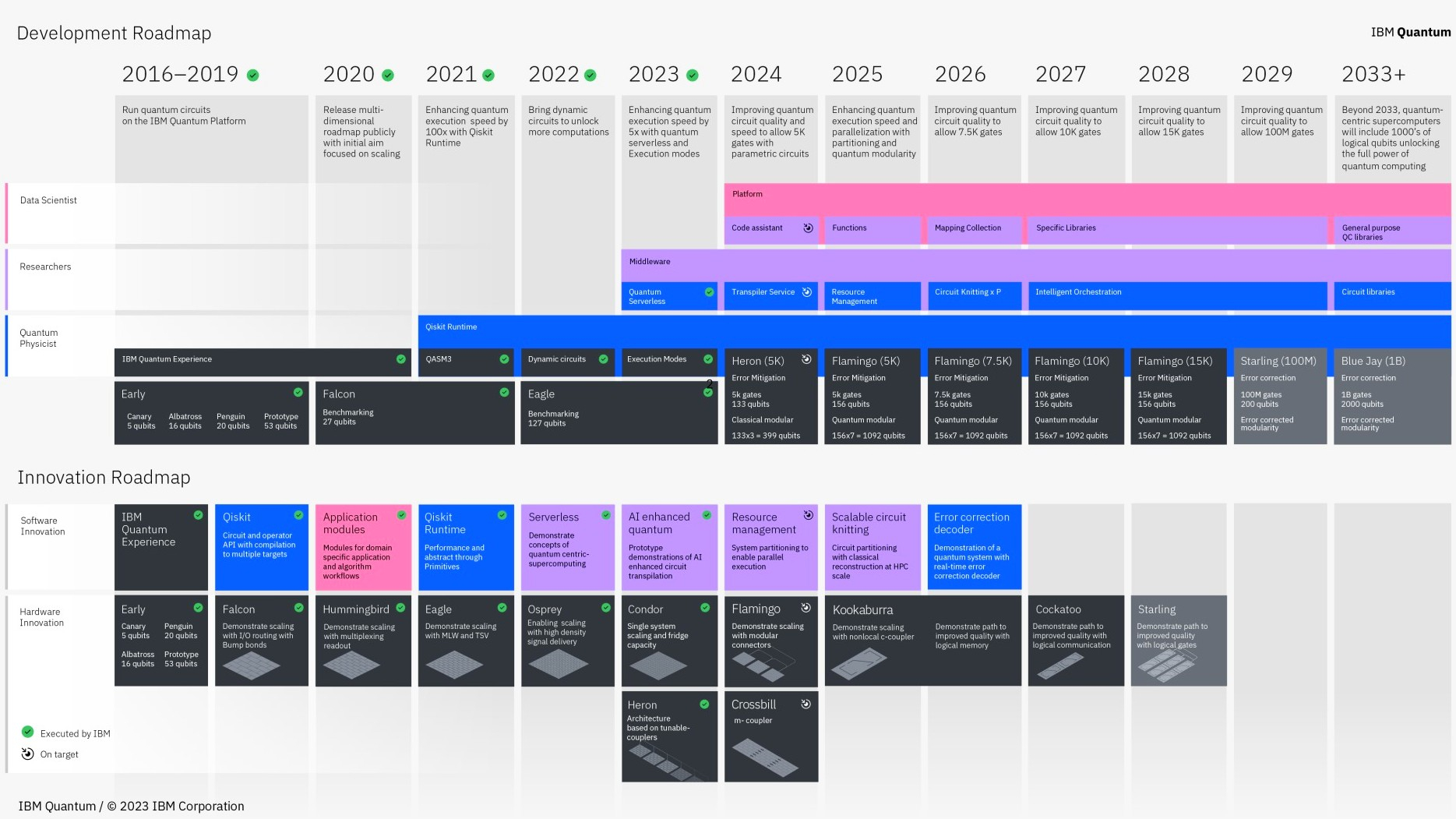

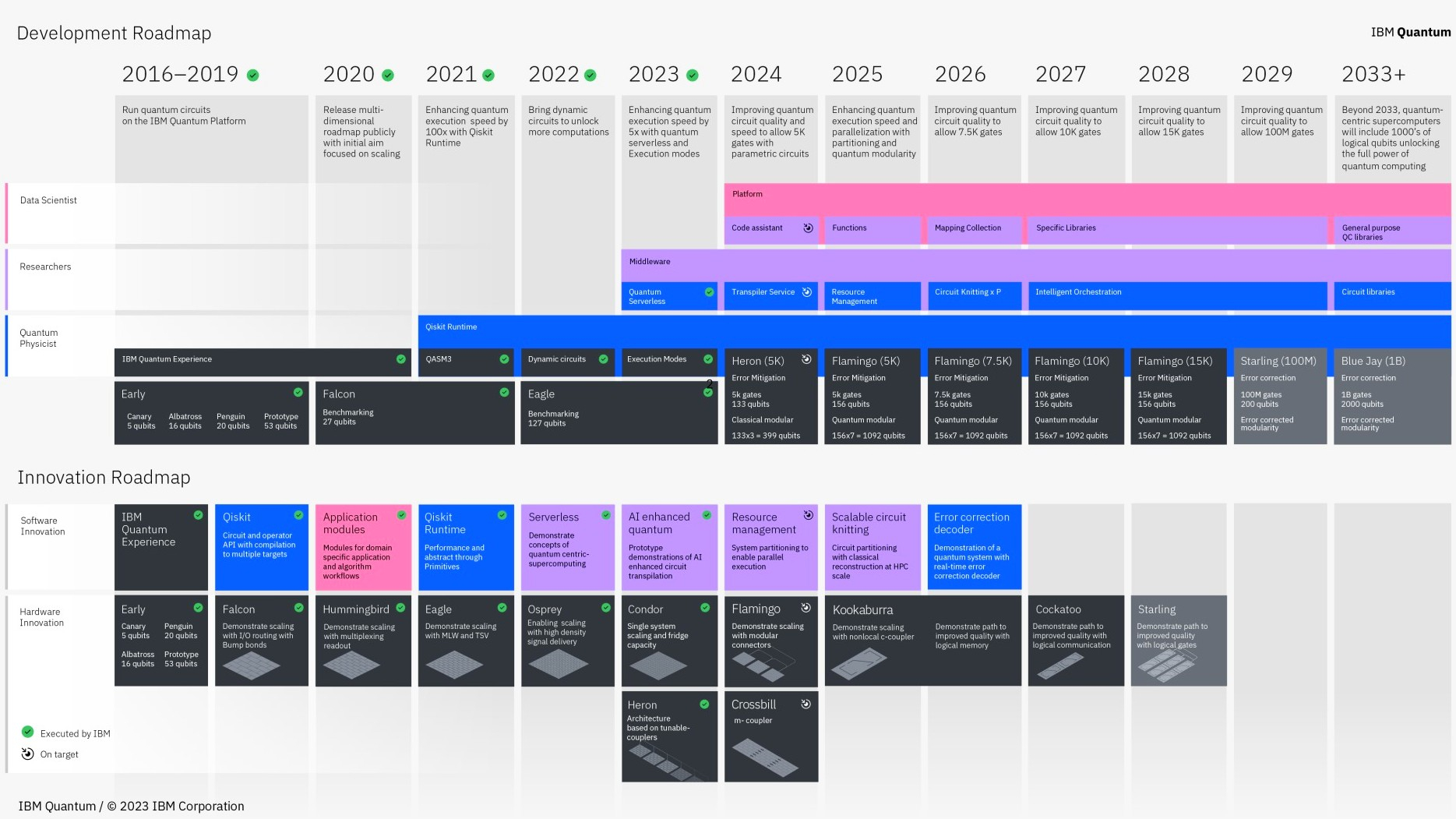

Новая дорожная карта IBM Quantum подробно описывает программное обеспечение и аппаратные технологии, необходимые для обеспечения квантового преимущества, используя которые квантовая система сможет решать задачи, не доступные для традиционных компьютеров. Нерешённые проблемы в области искусственного интеллекта, химии, финансовых услуг, наук о жизни, физики и фундаментальных исследований могут, наконец, стать решаемыми, что сделает результаты близкими для человечества. Зелёные галочки на дорожной карте отмечают уже достигнутые этапы.

Следующим крупным достижением в области квантовых вычислений должен стать в 2025 году процессор Kookaburra, который выступит в роли «базового строительного блока», из которых будут строиться масштабируемые системы с коррекцией ошибок в режиме реального времени. В IBM заявили, что исследователи также пытаются использовать квантовые системы для поиска корреляций в больших объёмах данных и решения так называемых проблем оптимизации, которые могут помочь улучшить бизнес-процессы.

Текущая дорожная карта IBM формирует представление одного из ведущих разработчиков квантовых вычислений о дальнейшем развитии этой сферы на ближайшие десять лет. Ожидания того, что квантовые системы к настоящему времени будут близки к коммерческому использованию, в последние годы вызвали волну финансирования этой технологии. Но признаки того, что бизнес-приложения отстают от ожиданий, привели к предупреждениям о возможной «квантовой зиме» ослабления доверия инвесторов и финансовой поддержки.

Исследователи IBM убеждены, что квантовые вычисления начинают демонстрировать свою востребованность в качестве важнейшего инструмента научных исследований. «Впервые у нас есть достаточно большие и мощные системы, чтобы с их помощью можно было выполнять полезную техническую и научную работу» — заявил руководитель отдела исследований IBM Quantum Дарио Хил (Dario Gil). Он также отметил, что «видит очень здоровую промышленную базу, которая инвестирует в технологии», а компании, использующие квантовые системы IBM в рамках своей научно-исследовательской деятельности, продолжают инвестировать «циклически».

«Пройдёт некоторое время, прежде чем мы перейдём от научной ценности к, скажем так, коммерческой ценности, — уверен Джей Гамбетта (Jay Gambetta), вице-президент IBM по квантовым технологиям. — Но, по моему мнению, разница между исследованиями и коммерциализацией становится все меньше».

Источник:

Для просмотра ссылки Войди или Зарегистрируйся