XUC

второе пришествие

- Регистрация

- 3 Сен 2006

- Сообщения

- 851

- Реакции

- 562

- Автор темы

- #91

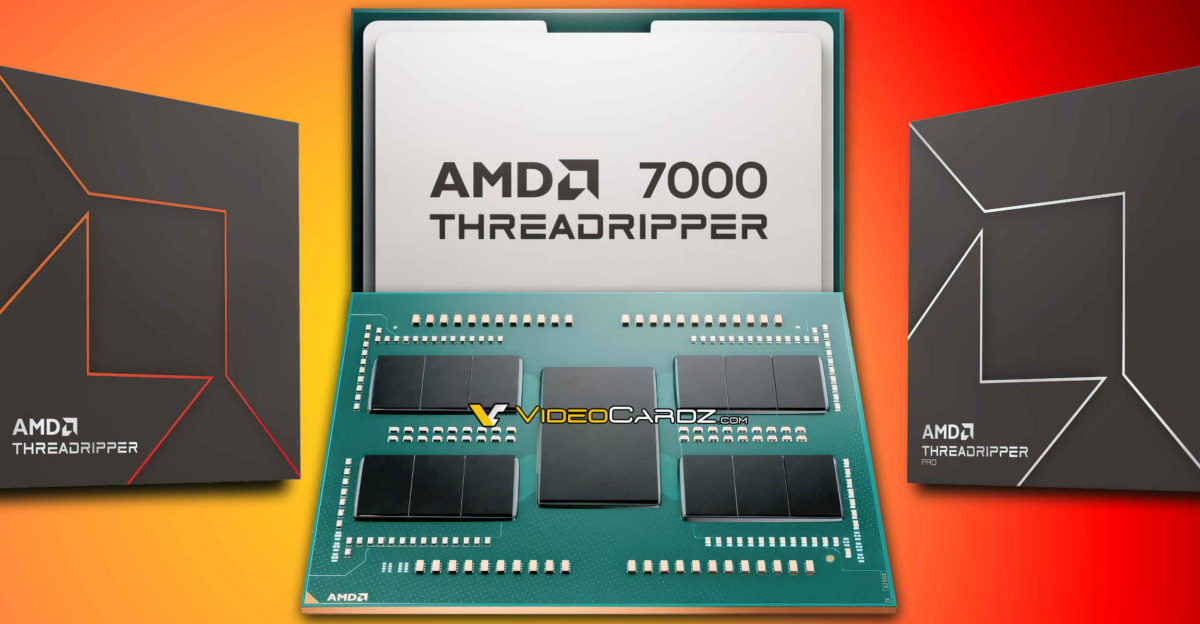

Сколько лет теперь Intel будет догонять этот процессор? Появились тесты 96-ядерного Ryzen Threadripper Pro 7995WX

Он почти в полтора раза быстрее самого лучшего CPU Intel

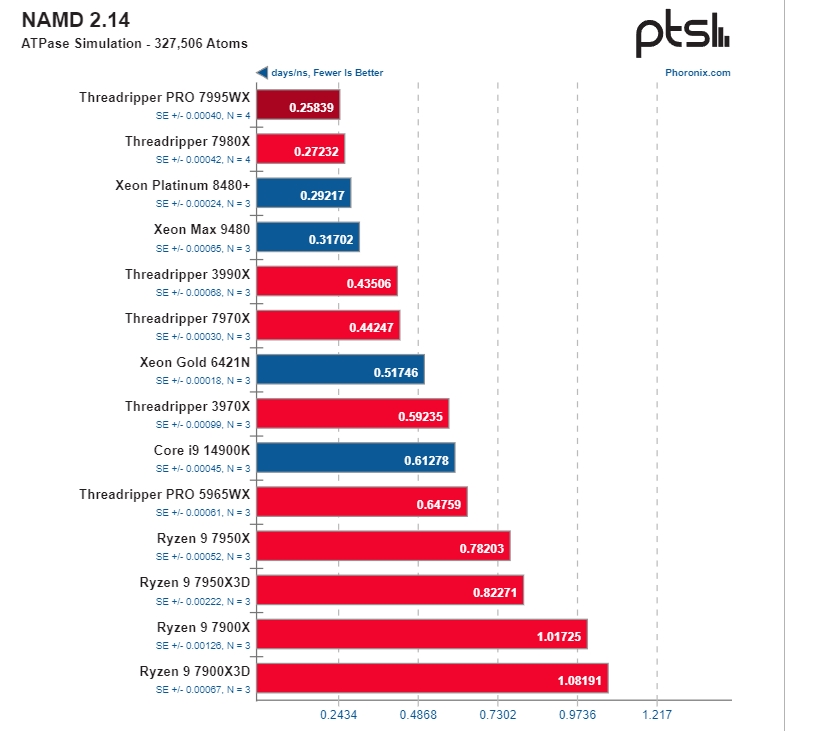

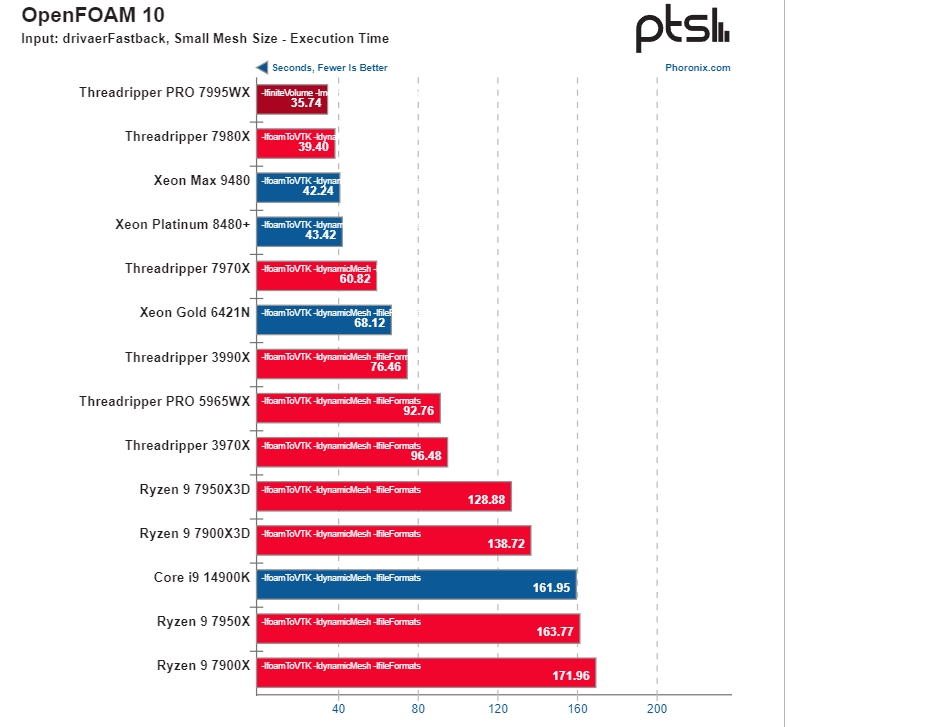

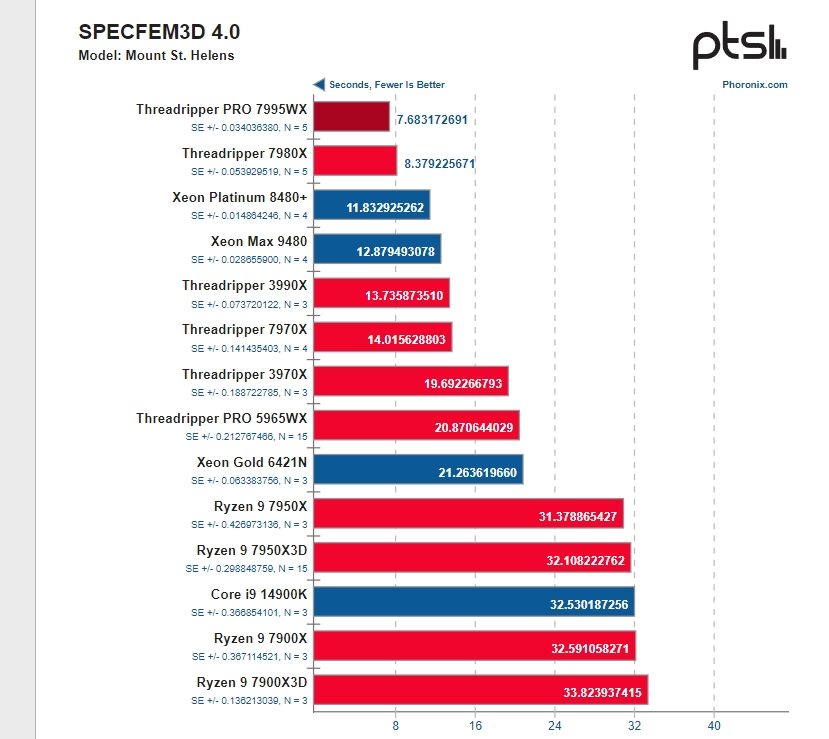

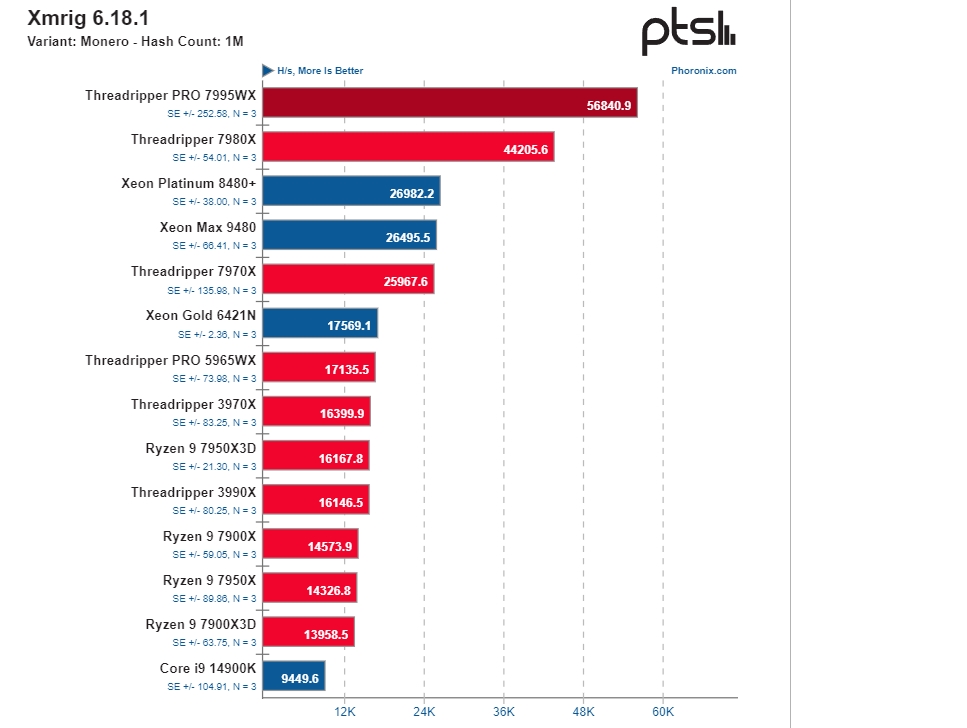

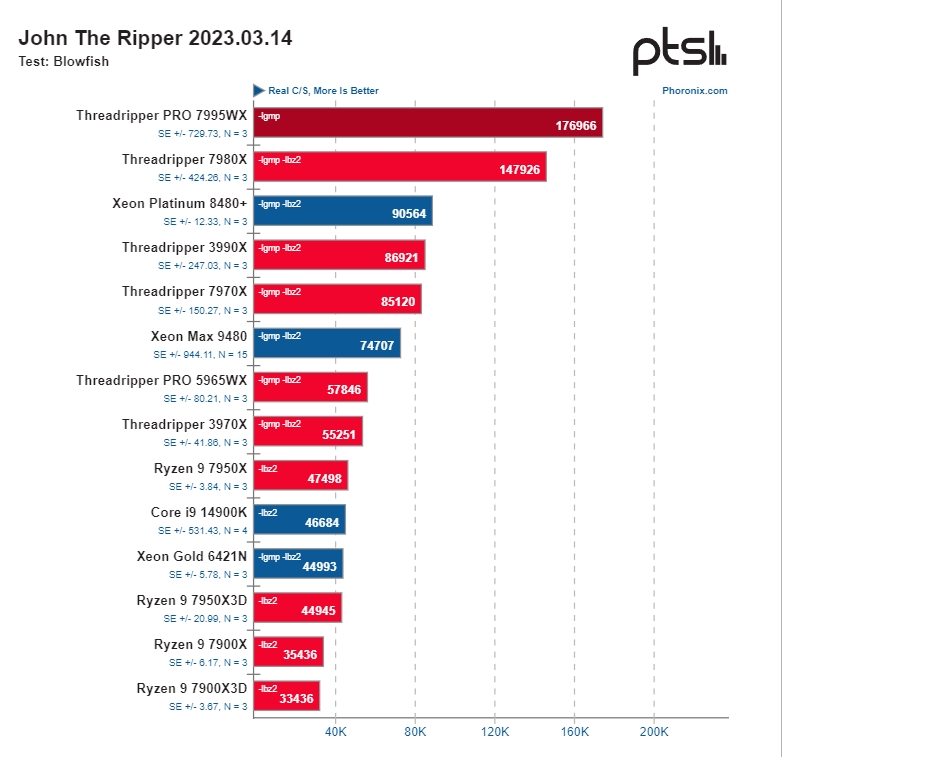

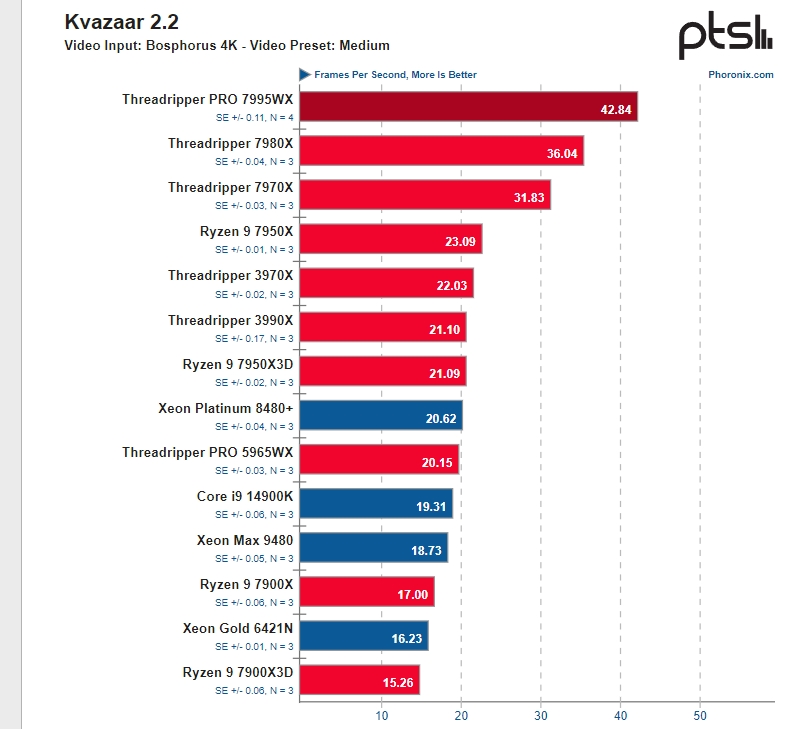

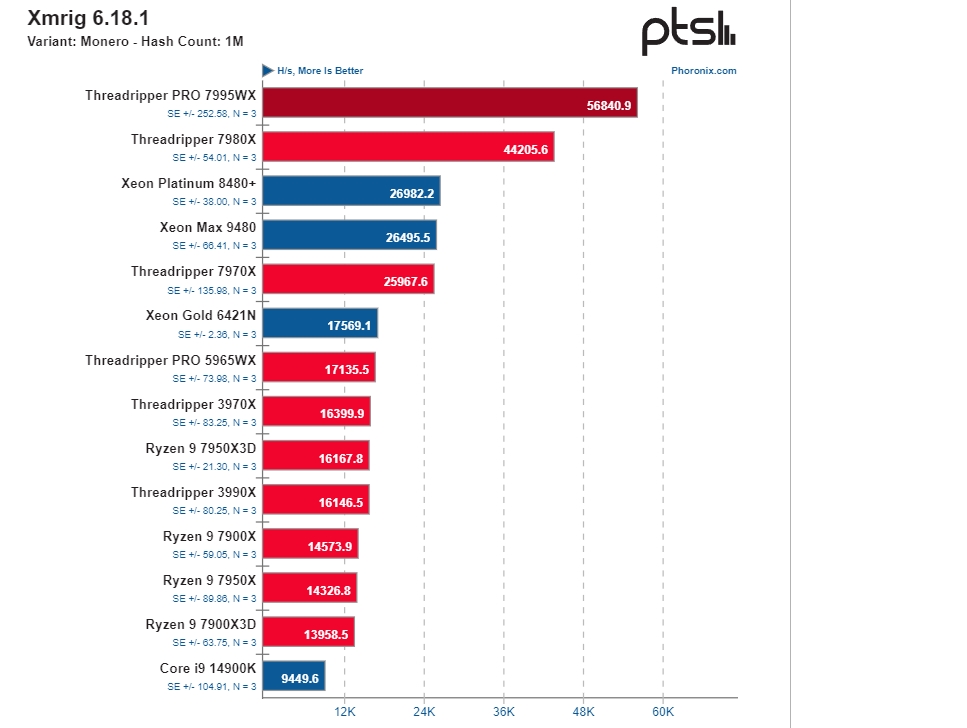

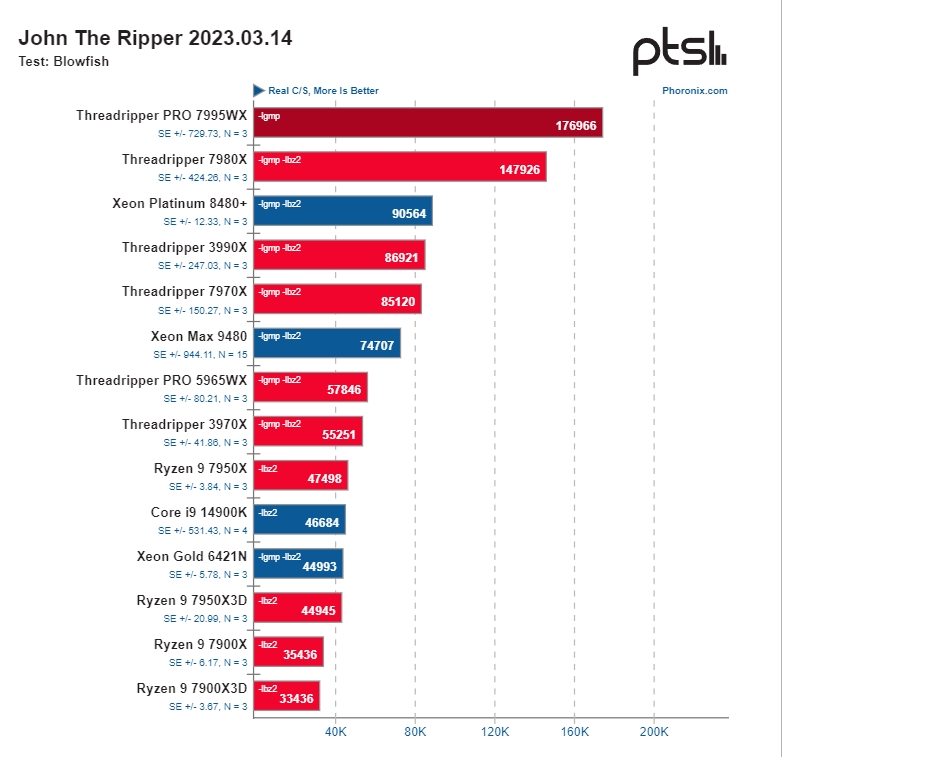

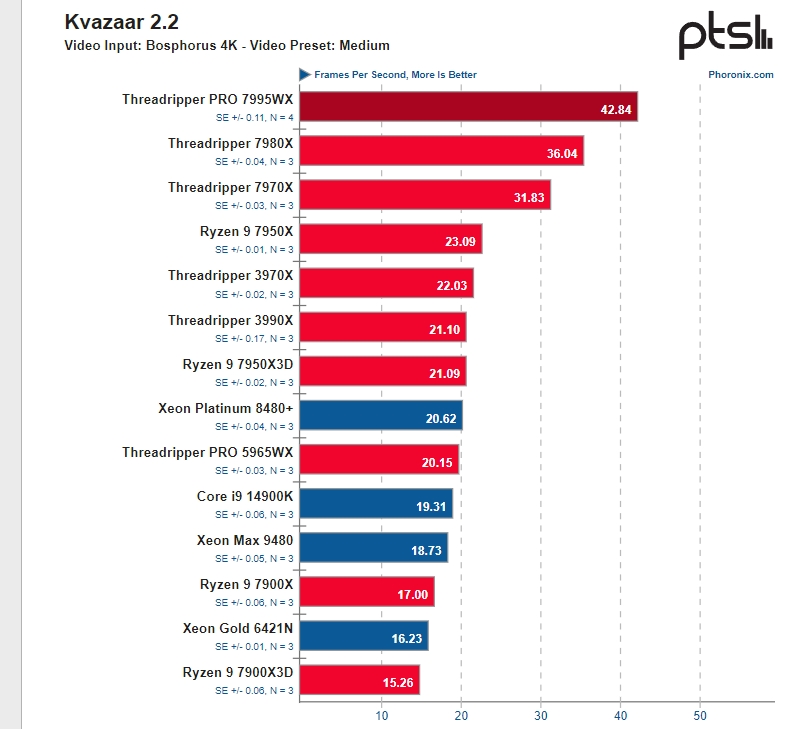

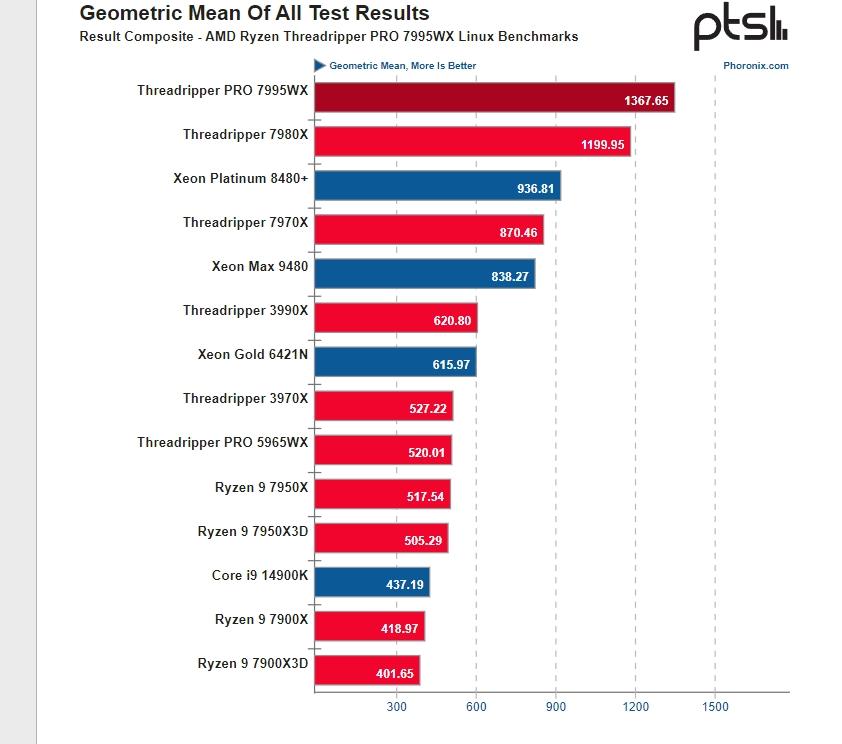

Мы уже ознакомились с тестами 64-ядерного Threadripper 7980X, который порой показывает какую-то невозможную производительность относительно предшественника. Но у AMD есть ещё более впечатляющее решение: 96-ядерный Threadripper Pro 7995WX. И его полноценный обзор пока вышел только у Phoronix, причём при использовании под управлением Linux.

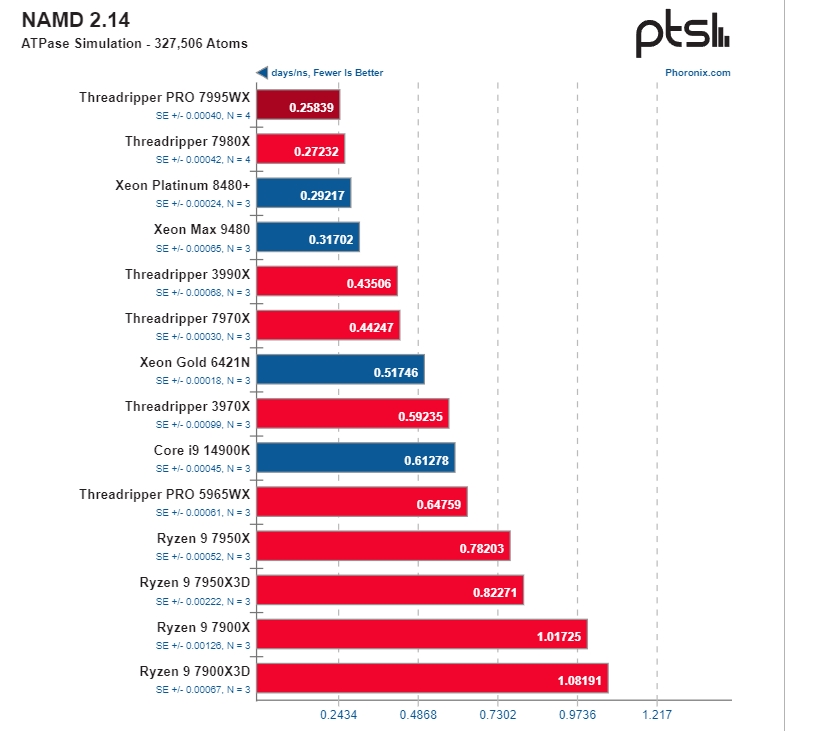

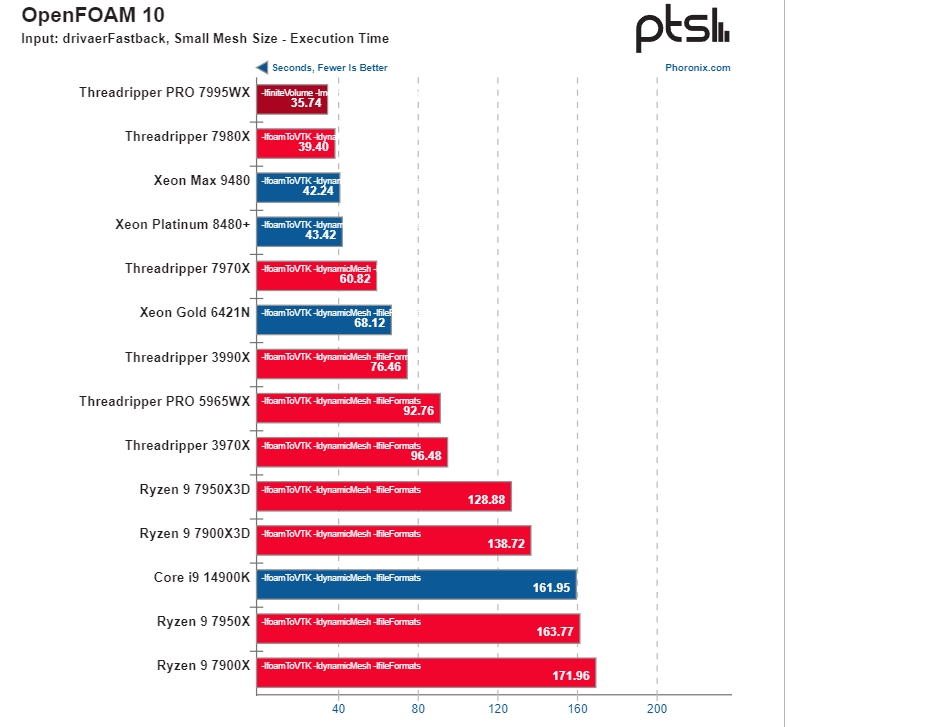

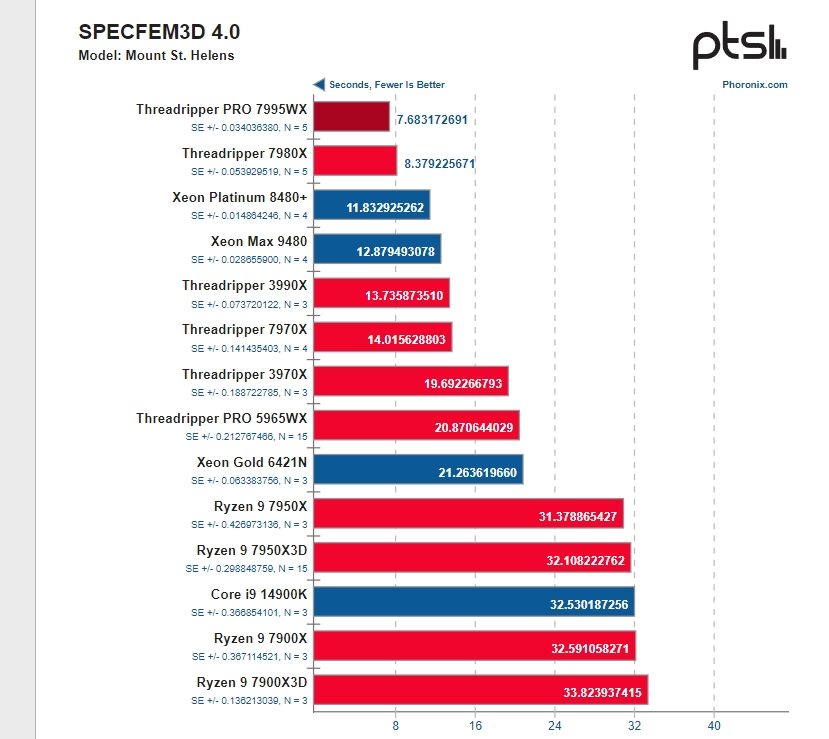

Тестов у источника очень много, так что для полноты картины лучше ознакомиться с оригинальной статьёй, мы же выделим самые показательные.

К сожалению, у источника не было Threadripper 5995WX для полноты сравнения, но зато были Xeon Platinum и Xeon Max.

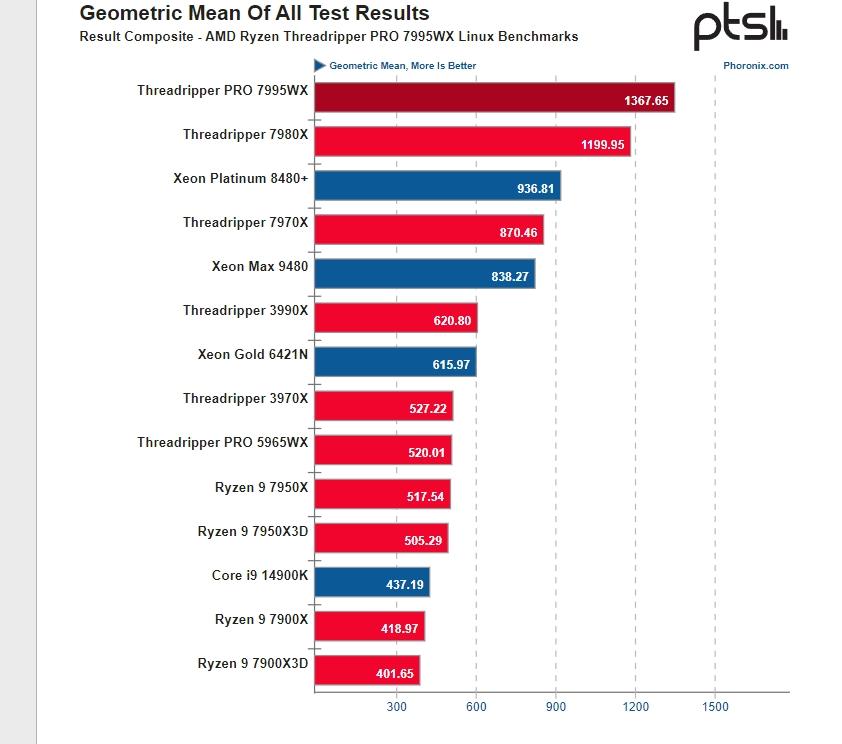

Как можно видеть, в большинстве тестов новые CPU AMD на голову превосходят современные процессоры Intel. Причём по среднему показателю даже 64-ядерный Threadripper 7980X смотрится намного лучше Xeon Platinum 8480+, а ничего лучше у Intel попросту нет. Ну а 96-ядерный Threadripper Pro 7995WX быстрее флагмана Intel чуть ли не в полтора раза.

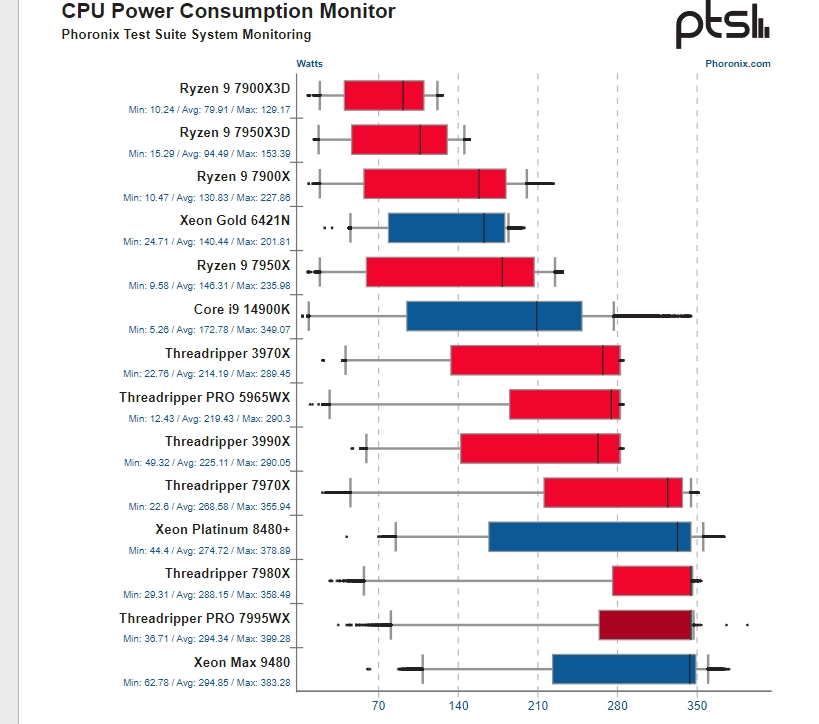

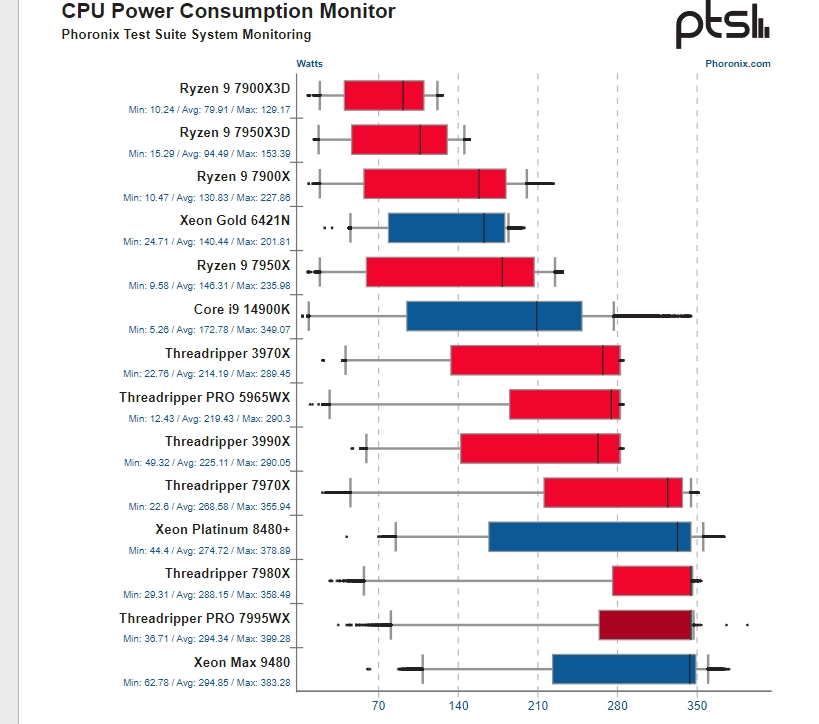

По энергопотреблению AMD также лучше. Средний показатель 96-ядерного составляет 294 Вт, что максимально близко к 288 Вт у 64-ядерного Threadripper 7980X. Процессоры Intel потребляют примерно столько же при намного меньшей производительности.

Источник Для просмотра ссылки Войдиили Зарегистрируйся

Он почти в полтора раза быстрее самого лучшего CPU Intel

Мы уже ознакомились с тестами 64-ядерного Threadripper 7980X, который порой показывает какую-то невозможную производительность относительно предшественника. Но у AMD есть ещё более впечатляющее решение: 96-ядерный Threadripper Pro 7995WX. И его полноценный обзор пока вышел только у Phoronix, причём при использовании под управлением Linux.

Тестов у источника очень много, так что для полноты картины лучше ознакомиться с оригинальной статьёй, мы же выделим самые показательные.

К сожалению, у источника не было Threadripper 5995WX для полноты сравнения, но зато были Xeon Platinum и Xeon Max.

Как можно видеть, в большинстве тестов новые CPU AMD на голову превосходят современные процессоры Intel. Причём по среднему показателю даже 64-ядерный Threadripper 7980X смотрится намного лучше Xeon Platinum 8480+, а ничего лучше у Intel попросту нет. Ну а 96-ядерный Threadripper Pro 7995WX быстрее флагмана Intel чуть ли не в полтора раза.

По энергопотреблению AMD также лучше. Средний показатель 96-ядерного составляет 294 Вт, что максимально близко к 288 Вт у 64-ядерного Threadripper 7980X. Процессоры Intel потребляют примерно столько же при намного меньшей производительности.

Источник Для просмотра ссылки Войди